L-Mul คืออะไร? อัลกอริทึมแบบใหม่นี้ลดการใช้พลังงานของ AI ลงมากถึง 95% โดยไม่กระทบต่อความแม่นยำและความเร็วมากนักได้อย่างไร?

เนื่องจากการใช้งาน AI มีมากขึ้นเรื่อย ๆ และทั้งการใช้และการเทรด AI การต้องใช้พลังงานมาก ซึ่งถ้าลองเปรียบเทียบการใช้พลังงานเมื่อเกิดการเสิร์ช Google กับการคุยกับ Chatbot AI อย่าง ChatGPT แล้ว การค้นหาบน Google แบบทั่วไปจะใช้พลังงานไฟฟ้าเฉลี่ย 0.3 ยูนิต (วัตต์-ชั่วโมง) ในขณะที่การสนทนากับ AI เช่น ChatGPT จะใช้พลังงานประมาณ 2.9 ยูนิต (วัตต์-ชั่วโมง) หรือมากกว่าเกือบ 10 เท่า

ทำไม AI ถึงใช้พลังงานเยอะ?

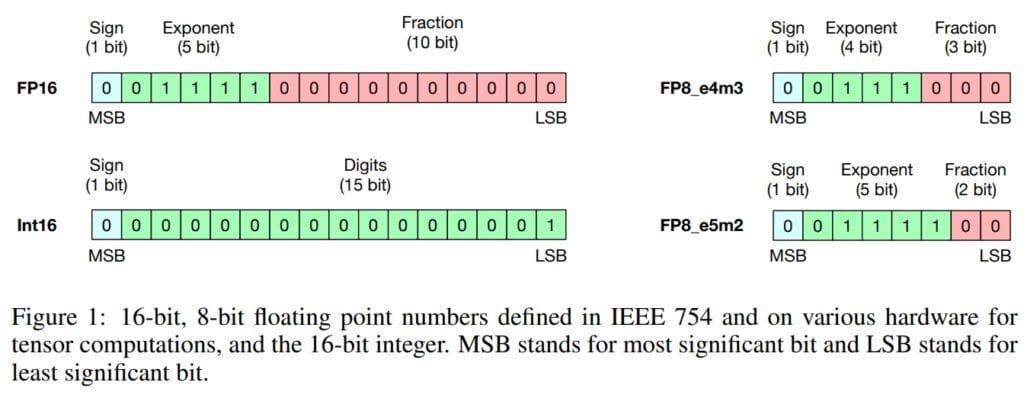

ตัวเลขจุดทศนิยมถูกใช้กันอย่างแพร่หลายในการคำนวณ AI เพื่อการคำนวณที่แม่นยำ แต่ความแม่นยำนี้มีค่าใช้จ่าย และเมื่อมีการใช้ AI ที่มากขึ้นก็จะมีความต้องการใช้พลังงานเพิ่มขึ้นจนน่ากังวล โดยบางโมเดล AI ต้องการไฟฟ้าจำนวนมหาศาล ตัวอย่างเช่น ChatGPT ใช้ไฟฟ้าเทียบเท่ากับบ้าน 18,000 หลังในสหรัฐอเมริกา (564 MWh ต่อวัน) นักวิเคราะห์ที่ Cambridge Centre for Alternative Finance ประมาณการว่าอุตสาหกรรม AI อาจใช้พลังงานอยู่ระหว่าง 85 ถึง 134 TWh ต่อปีภายในปี 2027

L-Mul คืออะไร?

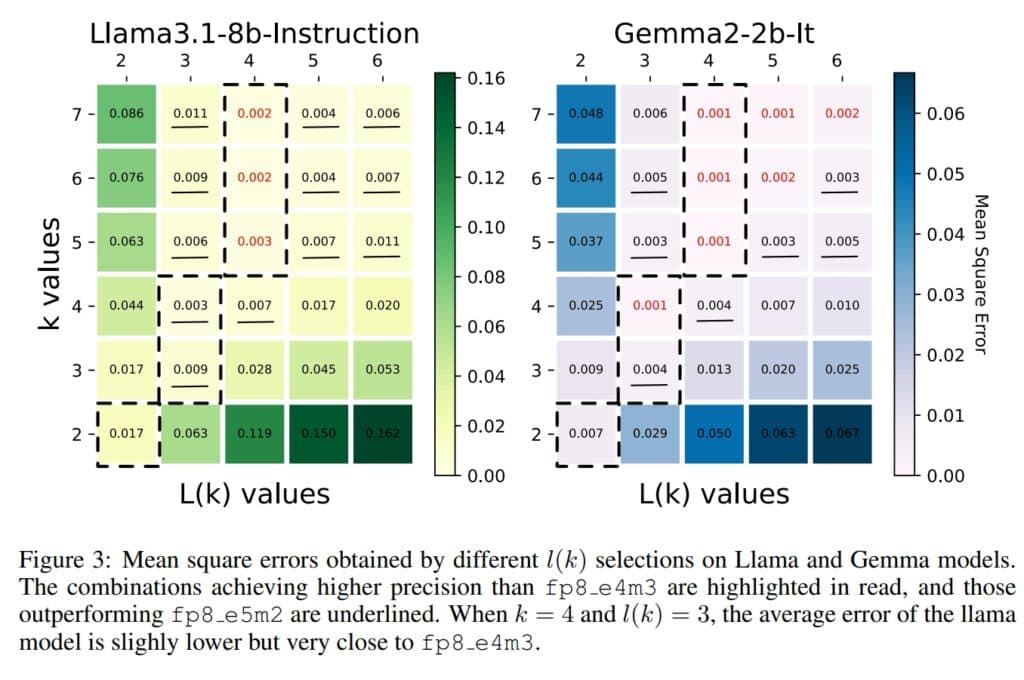

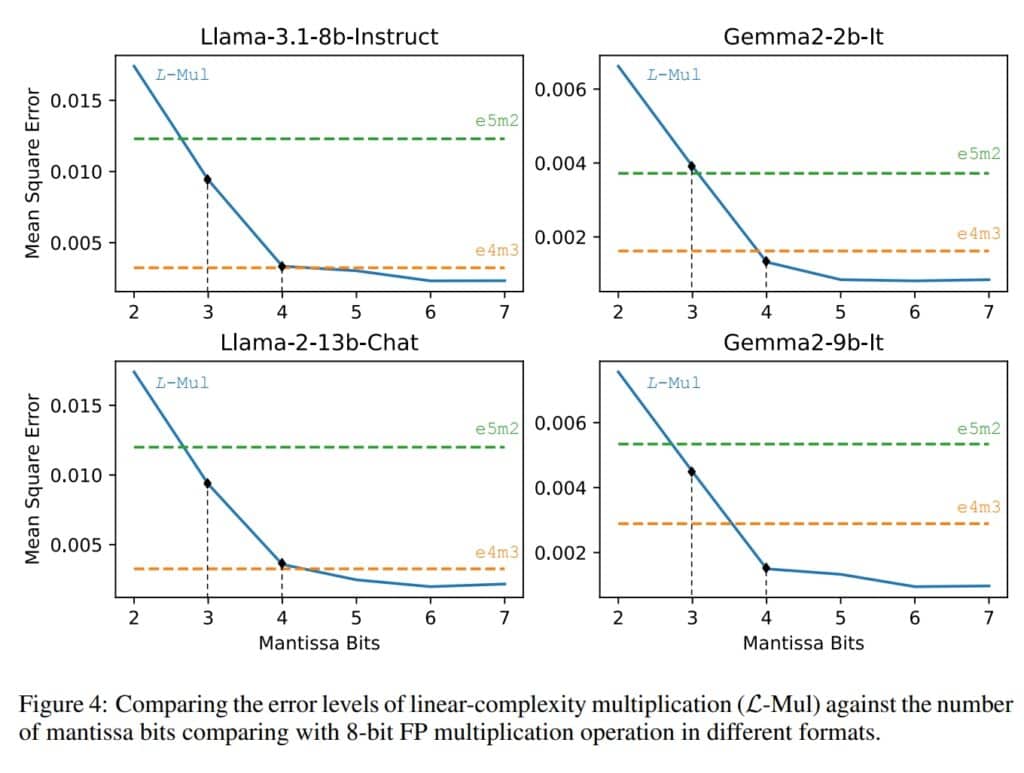

นักวิจัยที่ BitEnergy AI ได้พัฒนาเทคนิคที่สามารถลดการใช้พลังงานของ AI ได้อย่างมากโดยไม่กระทบต่อความแม่นยำและความเร็วมากเกินไป การศึกษาอ้างว่าวิธีการดังกล่าวสามารถลดการใช้พลังงานได้มากถึง 95 เปอร์เซ็นต์ ซึ่งทีมวิจัยเรียกวิธีแบบใหม่นี้ว่า Linear-Complexity Multiplication หรือ L-Mul โดยกระบวนการคำนวณนี้ใช้การบวกจำนวนเต็ม ซึ่งต้องใช้พลังงานน้อยกว่าและขั้นตอนน้อยกว่าการคูณจุดทศนิยมสำหรับงานที่เกี่ยวข้องกับ AI

อัลกอริทึม L-Mul แก้ไขการสิ้นเปลืองพลังงานที่มากเกินไปนี้โดยประมาณการคูณจุดทศนิยมที่ซับซ้อนด้วยการบวกจำนวนเต็มที่ง่ายกว่า ในการทดสอบ โมเดล AI นี้ยังคงมีความแม่นยำในขณะที่สามารถลดการใช้พลังงานลง 95 เปอร์เซ็นต์สำหรับการคูณเทนเซอร์ (Tensor Multiplications) และ 80 เปอร์เซ็นต์สำหรับผลคูณจุด (Dot Products)

การใช้งาน L-Mul กับโมเดล AI ต่าง ๆ

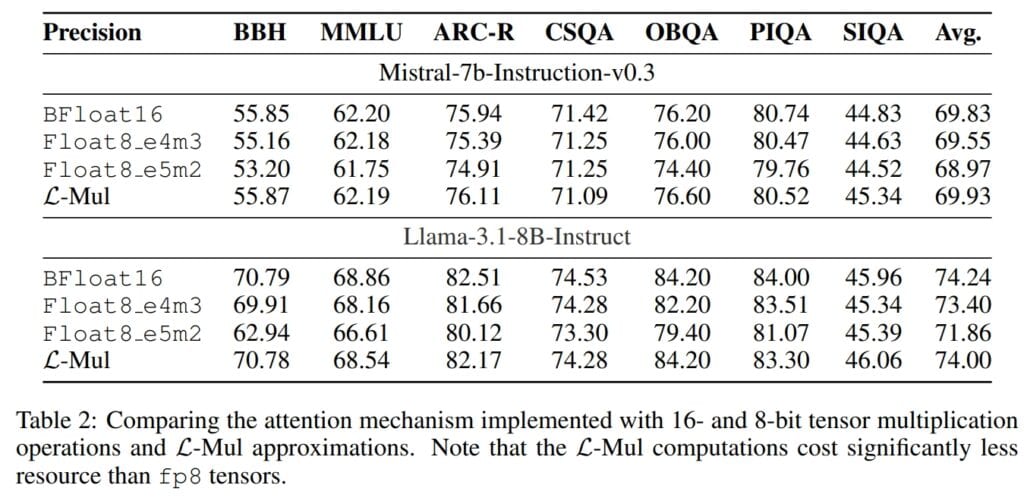

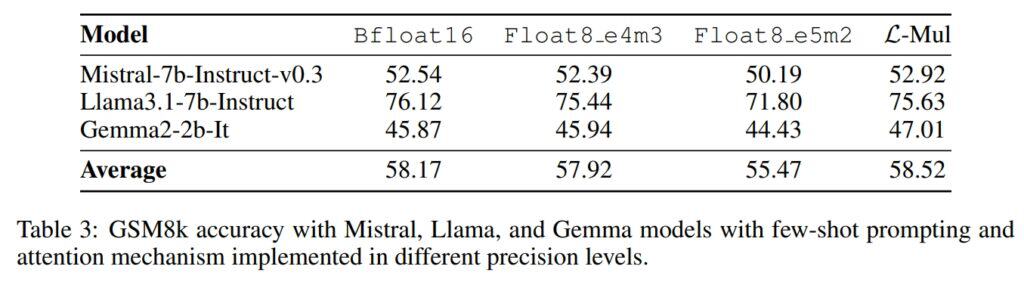

เทคนิค L-Mul ยังมีประสิทธิภาพเพิ่มขึ้นตามสัดส่วน อัลกอริทึมในปัจจุบันคำนวณที่ระดับ 8 บิต และจะมีความแม่นยำสูงขึ้นด้วยการคำนวณระดับบิตที่น้อยลง การทดสอบนี้ครอบคลุมงาน AI ต่างๆ รวมถึงการประมวลผลภาษาธรรมชาติ (Large Language Model หรือ LLM) และ Computer Vision แสดงให้เห็นถึงประสิทธิภาพที่ลดลงเพียง 0.07 % เท่านั้น นับว่าเป็นการแลกเปลี่ยนที่เล็กน้อยมาก เมื่อพิจารณาถึงการประหยัดพลังงาน

ขณะที่โมเดลที่ใช้ Transformer เช่น GPT จะได้รับประโยชน์สูงสุดจาก L-Mul เพราะอัลกอริทึมที่ทใช้ในโมเดลนี้ใช้พลังงานสิ้นเปลืองมาก และการทดสอบกับโมเดล AI ที่ได้รับความนิยม เช่น Llama และ Mistral ก็แสดงให้เห็นถึงความแม่นยำที่เพิ่มขึ้นกับงานบางอย่าง ถึง L-Mul จะมีข้อดีมากมาย แต่ก็มีข้อเสียที่ต้องปรับปรุงเช่นกัน

ข้อเสียของ L-Mul

ในปัจจุบัน L-Mul ต้องการฮาร์ดแวร์เฉพาะทาง การประมวลผล AI ในปัจจุบันยังไม่ได้รับการปรับให้เหมาะสมเพื่อใช้ประโยชน์จากเทคนิคดังกล่าว แต่ข่าวดีก็คือ แผนการพัฒนาฮาร์ดแวร์เฉพาะทางและการเขียนโปรแกรม API อยู่ระหว่างดำเนินการ ซึ่งจะช่วยปูทางไปสู่ AI ที่ประหยัดพลังงานมากขึ้นภายในกรอบเวลาที่เหมาะสม

อ้างอิง arxiv.org และ cover reflectorbital.com

อ่านบทความและข่าวอื่นๆเพิ่มเติมได้ที่ it24hrs.com

L-Mul คืออะไร อัลกอริทึมแบบใหม่นี้ช่วยให้ AI ลดการใช้พลังงานได้อย่างไร?

อย่าลืมกดติดตามอัพเดตข่าวสาร ทิปเทคนิคดีๆกันนะคะ Please follow us

Youtube it24hrs

Twitter it24hrs

Tiktok it24hrs

facebook it24hrs